El avance de la tecnología de inteligencia artificial (IA) ha experimentado un salto cuántico con el lanzamiento del Nvidia Blackwell B200 GPU. Este dispositivo no solo sucede al chip H100 de AI, sino que lo supera en rendimiento y eficiencia, estableciendo un nuevo estándar en el procesamiento de IA.

Características Clave del Blackwell B200

Rendimiento Excepcional de 20 Petaflops

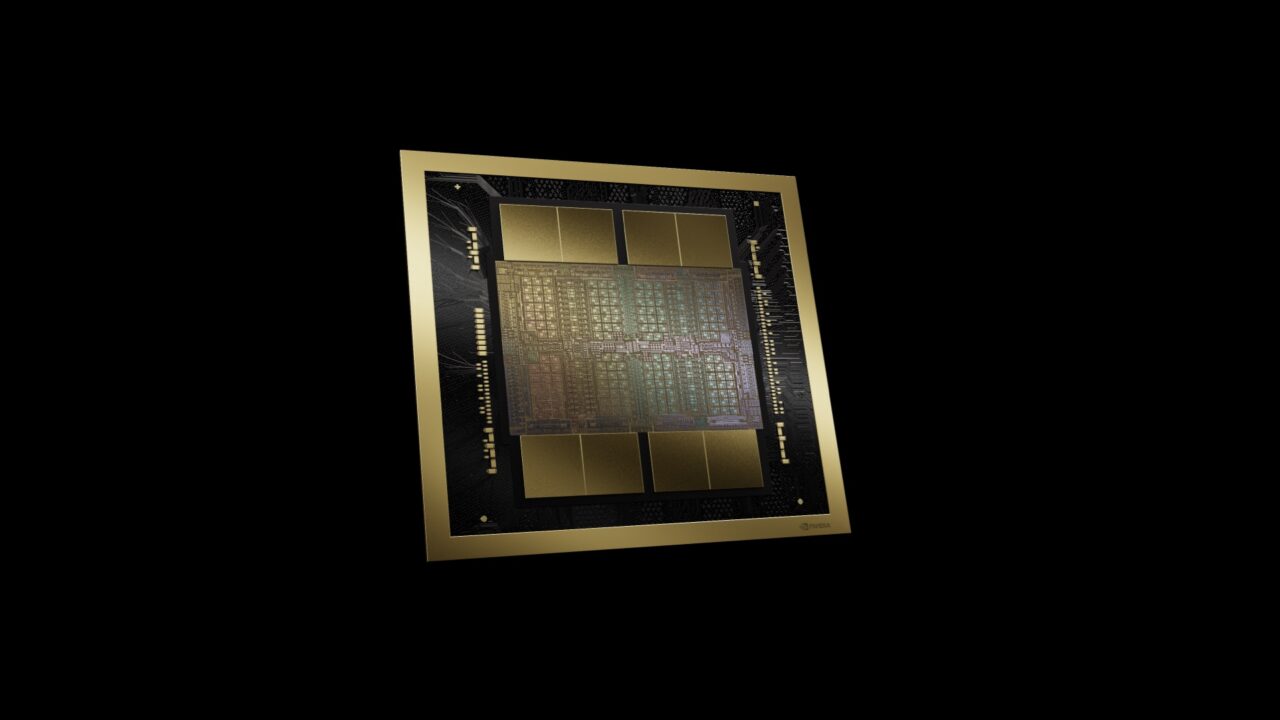

El B200 de Nvidia es una obra maestra de la ingeniería, capaz de entregar 20 petaflops de capacidad de procesamiento FP4. Este rendimiento se apoya en sus 208 mil millones de transistores, facilitando una potencia de cálculo sin precedentes.

Tecnología de Transistores Avanzada

La base de esta potencia radica en la avanzada tecnología de transistores que incorpora, permitiendo un procesamiento más rápido y eficiente que redefine los límites de la computación de IA.

Comparación de Rendimiento: Blackwell B200 vs. H100

Mejoras en la Inferencia de Modelos de Lenguaje

Comparativamente, el B200 es 30 veces más potente que su predecesor H100 en tareas de inferencia para modelos de lenguaje grande, como GPT-3, y consigue ser siete veces más rápido en el benchmark específico de GPT-3.

Reducción Significativa en el Consumo Energético

Además, el Blackwell B200 logra una reducción de consumo energético de 25 veces en comparación con el H100, destacando su diseño orientado a la sostenibilidad y la eficiencia energética.

Innovación en la Eficiencia: El Diseño del Blackwell B200

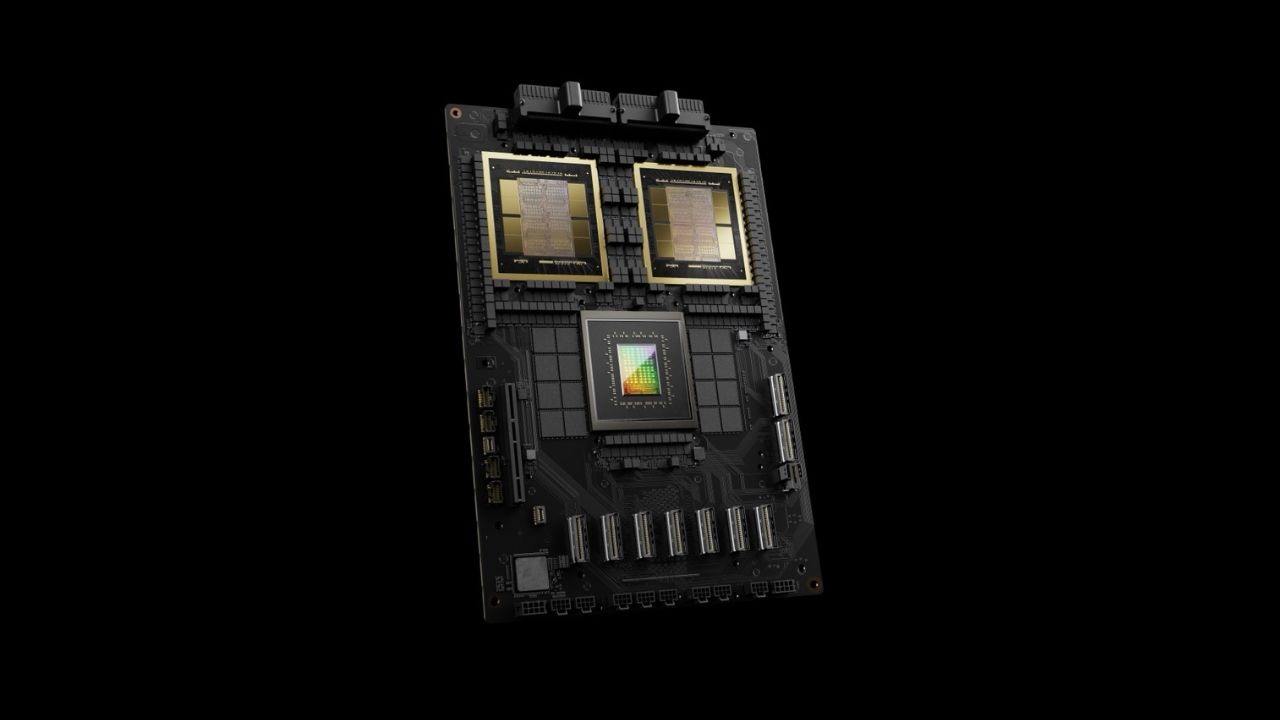

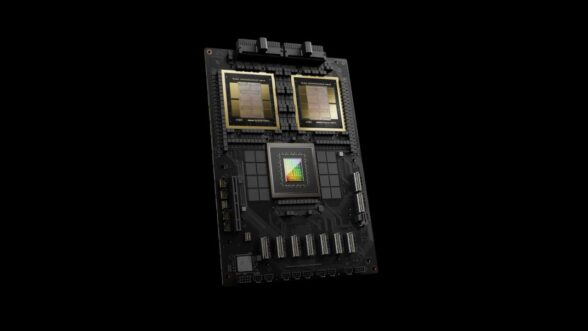

La Nueva Arquitectura de Switch para GPUs

Nvidia ha innovado con un chip de switch de red que posee 50 mil millones de transistores, capaz de integrar 576 GPUs y permitir comunicaciones bidireccionales a velocidades de 1.8 TB/s, mejorando significativamente la eficiencia en la comunicación entre GPUs.

Optimización de la Comunicación entre GPUs

Este avance resuelve los desafíos de comunicación previos, donde sistemas de 16 GPUs podían pasar hasta un 60% del tiempo en comunicación en lugar de cálculo, optimizando así el tiempo y recursos computacionales.

Soluciones Integradas de Nvidia: Un Ecosistema Completo

Sistemas NVL72 y DGX Superpod

Nvidia ofrece soluciones integradas como el NVL72, que admite 36 CPUs y 72 GPUs en un solo rack refrigerado por líquido, y el DGX Superpod, que combina ocho de estos sistemas en uno.

Colaboración con Gigantes de la Nube

Empresas como Oracle, Amazon, Google y Microsoft ya han anunciado planes para integrar los racks NVL72 en sus servicios de nube, demostrando la confianza y el interés en la capacidad y eficiencia del Blackwell B200.

Impacto en el Mercado y Futuras Implementaciones

Adopción por Parte de Empresas Líderes

La adopción del Blackwell B200 por gigantes tecnológicos refleja su impacto significativo en el mercado de la computación de IA, proyectando un futuro donde la eficiencia y el rendimiento son primordiales.

Influencia en las Series RTX 5000

Se anticipa que la arquitectura del GPU Blackwell B200 será la base para las futuras series RTX 5000, marcando el inicio de una nueva era en la computación gráfica y de IA.

En conclusión, el Nvidia Blackwell B200 GPU no es solo un producto, sino una revolución en la computación de IA, destacando por su rendimiento, eficiencia y el ecosistema integrado que ofrece. Con su lanzamiento, Nvidia no solo establece un nuevo paradigma en la tecnología de procesamiento, sino que también allana el camino para futuras innovaciones en el campo de la IA.

Fuente: Nvidia